Eficiência de um Estimador

ESTAT0078 – Inferência I

Prof. Dr. Sadraque E. F. Lucena

sadraquelucena@academico.ufs.br

http://sadraquelucena.github.io/inferencia1

Nesta aula, exploraremos o conceito de estimador eficiente e aprenderemos a avaliar a eficiência de diferentes estimadores.

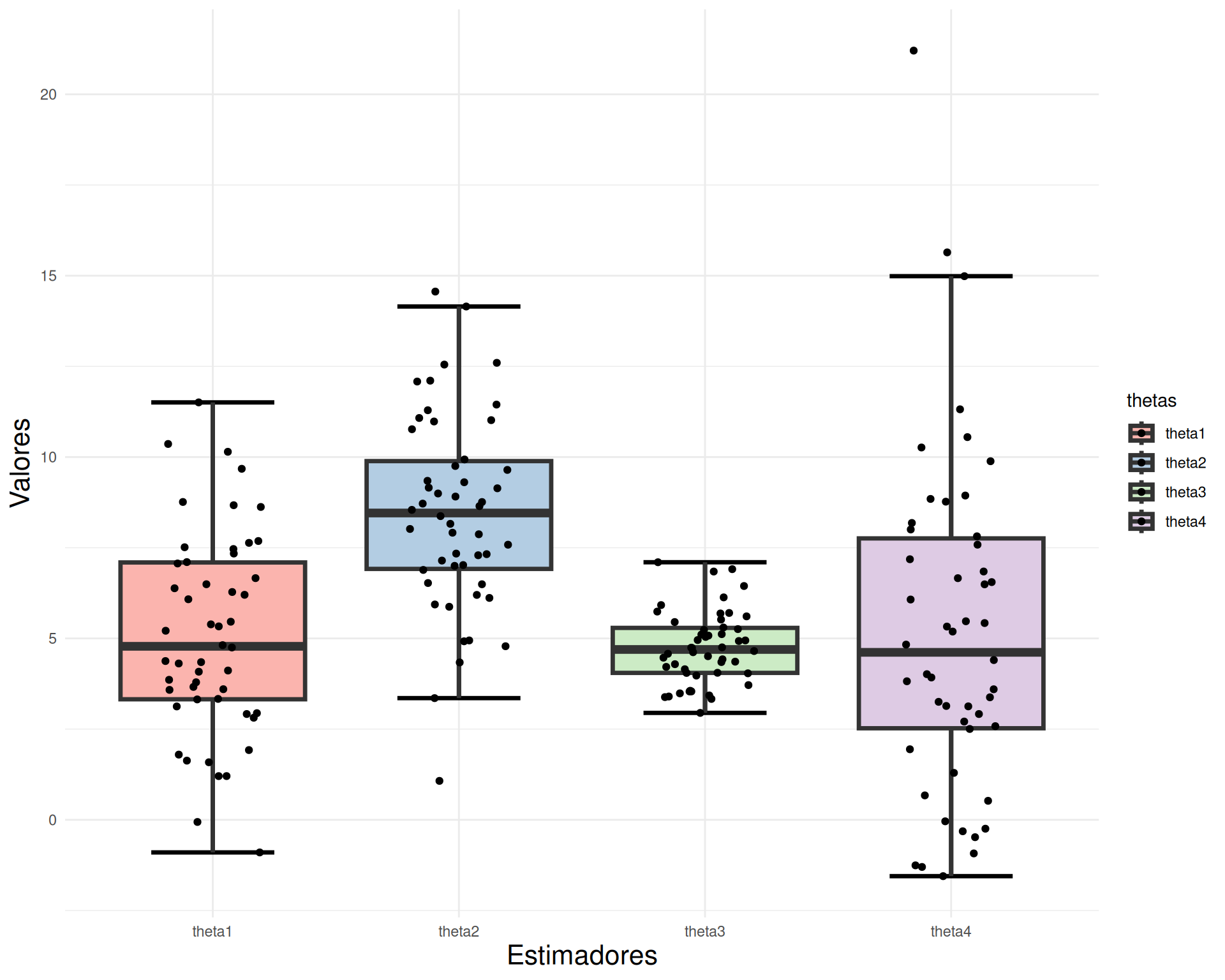

Um estimador é considerado mais eficiente quando possui uma variância menor em comparação com outros estimadores não viesados.

Existe, ainda, um método para determinar o menor limite possível para a variância de um estimador de um parâmetro \(\theta\). Caso um estimador atinja esse limite, ele será considerado o mais eficiente, pois nenhum outro terá uma variância menor do que a dele.

Definição 5.1: Eficiência de um estimador

Suponha que \(\widehat{\theta}\) seja não viesado para o parâmetro \(\theta\). Chamamos de eficiência do estimador \(\widehat{\theta}\) o quociente \[ e(\widehat{\theta}) = \frac{LI(\theta)}{Var(\widehat{\theta})}, \] em que \(LI(\theta)\) é o limite inferior da variância dos estimadores não viesados de \(\theta\).

- Note que \(e(\widehat{\theta})=1\) quando \(LI(\theta)=Var(\widehat{\theta})\). Nesse caso \(\widehat{\theta}\) é chamado eficiente.

Sob certas condições de regularidade (basicamente, o suporte não depende de \(\theta\) e é possível trocar a ordem das operações de derivação e integração) temos \[ LI(\theta) = \frac{1}{n\, E\left[ \left( \frac{\partial\log f(X|\theta)}{\partial \theta} \right)^{\!2} \right]} \] e \[ E\left[ \left( \frac{\partial \log f(X)}{\partial \theta} \right)^{\!2} \right] = -E\left[ \frac{\partial^2 \log f(X)}{\partial\theta^2.} \right]. \]

Para verificarmos se \(\widehat{\theta}\) é eficiente (de acordo com a Definição 5.1), seguimos os passos (sob certas condições de regularidade):

obtemos \(\ell = \log f(x)\);

derivamos \(\ell\) duas vezes, isto é, obtemos \(\ell''\);

calculamos \(E[\ell'']\);

obtemos \(LI(\theta)=\frac{1}{-nE[\ell'']}\);

calculamos \(Var(\widehat{\theta})\);

obtemos \(e(\widehat{\theta}) = \frac{LI(\theta)}{Var(\widehat{\theta})}\).

Exemplo 5.1

Seja \(X_1, \ldots, X_n\) uma amostra aleatória de \(X\sim N(\mu,\sigma^2)\), em que \(\sigma^2\) é conhecido. Verifique se \(\overline{X}\) é eficiente para \(\mu\).

Lembrete

Se \(X\sim N(\mu,\sigma^2)\), então \[f(x) = \frac{1}{\sigma\sqrt{2\pi}} e^{-\frac{(x-\mu)^2}{2\sigma^2}}, ~ -\infty<x<\infty\]

Exemplo 5.2

Seja \(X_1, \ldots, X_n\) uma amostra aleatória de tamanho \(n\) da variável aleatória \(X\sim \text{Poisson}(\theta)\). Verifique se \(\overline{X}\) é eficiente para \(\theta\).

Lembrete

Se \(X\sim \text{Poisson}(\theta)\), então \[f(x) = \frac{e^{-\theta}\theta^x}{x!}, ~ x=0,1,2,\ldots\]

Definição 5.2: Informação de Fisher

A quantidade \[ I_F(\theta) = E\left[ \left( \frac{\partial \log f(X)}{\partial \theta} \right)^{\!2} \right] \] é denominada informação de Fisher de \(\theta\).

Teorema 5.1: Desigualdade da Informação

Quando as condições de regularidade estão satisfeitas, a variância de qualquer estimador não viciado \(\widehat{\theta}\) do parâmetro \(\theta\) satisfaz a desigualdade \[ Var(\widehat{\theta}) \geq \frac{1}{n\,I_F(\theta)}. \]

É importante ressaltar que a desigualdade da informação não é um método para obter estimadores.

Ela apenas possibilita verificar se determinado estimador é ou não eficiente.

Exemplo 5.3

Seja \(X_1, \ldots, X_n\) uma amostra aleatória de tamanho \(n\) da variável aleatória \(X\sim \text{Bernoulli}(p)\). Verifique se \(\overline{X}\) é eficiente para \(p\).

Lembrete

Se \(X\sim \text{Bernoulli}(p)\), então

- \(f(x) = p^x (1-p)^{1-x}, ~ x=0,1\)

- \(E(X) = p\)

- \(Var(X)=p(1-p)\)

Exemplo 5.4

Seja \(X_1, \ldots, X_n\) uma amostra aleatória de tamanho \(n\) da variável aleatória \(X\sim \text{Geométrica}(p)\). Verifique se \(\overline{X}\) é eficiente para \(p\).

Lembrete

Se \(X\sim \text{Geométrica}(p)\), então

- \(f(x) = (1-p)^{x} p, ~ x=0,1, 2, 3\ldots\)

- \(E(X) = \frac{1-p}{p}\)

- \(Var(X)=\frac{1-p}{p^2}\)

Fim